爱思唯尔出版的国际权威期刊《Neural Networks》公布了2020年度唯一最佳论文奖。3200威尼斯vip张晓雷教授撰写的论文“Multilayer Bootstrap Networks”获此殊荣。该奖由担任该期刊Action Editor的西北工业大学校学术委员会副主任李学龙教授提名。

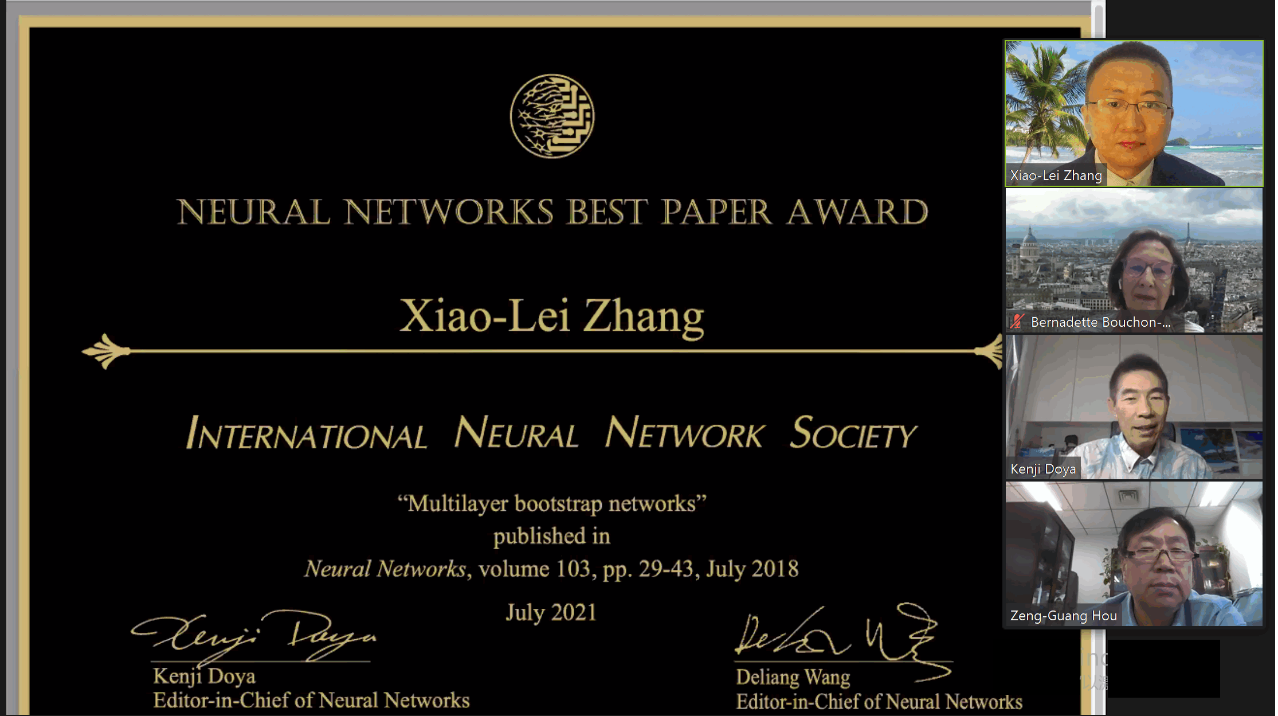

作为国际神经网络学会最重要的奖项之一,最佳论文奖的颁奖仪式于2021年7月22日在国际神经网络联合会议上举行(在线会议)。张晓雷教授作为该论文的唯一作者接受了《Neural Networks》共同主编DeLiang Wang教授和Kenji Doya教授、及国际神经网络学会主席Chrisina Jayne教授的联合授奖,以表彰该工作在人工智能与神经网络研究上的突出贡献。

《Neural Networks》是国际神经网络学会、欧洲神经网络学会和日本神经网络学会这三个世界上最早的神经网络学会的共同旗舰期刊,为现代人工智能技术革命的核心驱动力量“人工神经网络”提供了顶尖的发表与讨论平台。该期刊的收录范围涉及认知科学、神经科学、学习系统、数学和计算分析、工程与应用领域,涵盖人工神经网络研究的所有方面。该期刊的2020年影响因子为8.050,5年期影响因子为9.171,是JCR Q1期刊。

《Neural Networks》每年从该期刊两年前发表的所有论文中评选出年度唯一最佳论文奖。近年来,获奖论文的作者包括现代人工智能与深度学习的奠基人、世界著名的神经网络LSTM之父Jürgen Schmidhuber教授,计算神经科学的奠基人、国际神经网络学会的首任主席、《Neural Networks》首任主编Stephen Grossberg教授等。

2020年度《Neural Networks》最佳论文奖的评选活动于2020年8月启动,经过编委会100余位来自全球各地的编委共同参与提名和投票的严格评审程序,最终从该期刊2018年发表的220余篇论文中评选出该唯一最佳论文。

此次的获奖论文的主要贡献包括以下三点:(1)该论文提出了一种非线性数据降维算法-多层自举网络(multilayer bootstrap networks)。降维是统计学和机器学习的根本问题。论文所提算法使用最简单的数学运算达到了最佳的非线性降维性能:该算法所使用的数学运算仅有数据随机重采样、最近邻计算、堆栈三个基本元素;该算法在多个有区分性的代表性数据集上达到了最佳性能。例如,在将降维结果应用于聚类时在MNIST与20-Newsgroups的聚类精度分别达到96.6%和64.4%。

(2)该论文提出的算法是一种深度模型。与深度神经网络的优化方法不同,该算法不需要反向传播进行优化就可以建立有效的多层非线性深度网络。它同时克服了机器学习的多个研究困难点,具备无模型假设、同时支持大规模数据和小规模数据、对野点不敏感、没有局部最优化问题、易于被构建的极深等多个优点。

(3)该论文全面剖析了所提算法的几何和理论原理。与深度神经网络面临的难以解释、被视为黑盒问题的理论困难不同,该算法是一种几何原理清晰的白盒深度网络。该算法理论上植根于统计学中的频率学派,其设计遵循奥卡姆剃刀的“如无必要、勿增实体”原则。该论文证明了所提算法的损失可控性,揭示了基于柱状图的密度估计方法、自举统计方法、集成聚类、矢量量化、专家乘积、稀疏编码与字典学习、无监督深度学习的内在联系。

该获奖论文历经多年的积累和打磨才得以最终成稿。它填补了机器学习四大类非线性方法之一的集成学习方法在无监督降维问题上的长期空白,突破了深度神经网络依赖于反向传播算法进行优化的传统框架,实现了在机器学习算法研究上的原始创新,有力地促进了人工智能与深度学习在神经网络的可解释性、面向小数据的深度模型等基础研究方面的进展,以及数据挖掘、多媒体信息处理等领域相关应用技术的发展,具有突出的学术价值和社会意义。该获奖论文得到了国家自然科学基金的唯一资助。

审核:孙华强